当AI训练服务器的风扇开始轰鸣,屏幕上流动的数据如瀑布般倾泻,你是否曾好奇:这些昂贵的GPU究竟在如何工作?它们的算力是否被充分利用?GPU监控不仅是技术团队的日常任务,更是决定AI项目成本与效率的关键命脉。想象一下,一位厨师在米其林厨房同时照看十口锅——任何一刻的火候失控都可能毁掉整道盛宴。AI训...

当AI训练服务器的风扇开始轰鸣,屏幕上流动的数据如瀑布般倾泻,你是否曾好奇:这些昂贵的GPU究竟在如何工作?它们的算力是否被充分利用?GPU监控不仅是技术团队的日常任务,更是决定AI项目成本与效率的关键命脉。

想象一下,一位厨师在米其林厨房同时照看十口锅——任何一刻的火候失控都可能毁掉整道盛宴。AI训练中的GPU正是如此,它们的并行计算核心如同沸腾的灶台,需要精准的温度调控。专业运维团队会告诉你,忽视GPU监控就像让赛车手蒙眼驾驶,不仅浪费每度电0.8元起的算力成本,更可能让耗时数周的模型训练功亏一篑。

在深度学习工作流中,GPU使用率往往呈现三种典型状态:计算饱和的“黄金时段”、数据瓶颈的“饥饿等待”,以及内存交换的“交通堵塞”。真正的专家不会仅满足于nvidia-smi命令窗口里跳动的数字,而是像医生解读心电图般,从GPU-Util、Memory-Usage、Temperature三维度构建健康画像。当显存占用持续95%而使用率低于40%,往往预示着数据管道存在隐性疾病。

现代监控体系已进化出多层感知网络。基础层面依靠DCGM(Data Center GPU Manager)这类专业工具持续采集SM效率指标;中间层通过Prometheus时序数据库构建指标走廊;展示层则借助Grafana绘制出色彩斑斓的算力地图。某自动驾驶团队曾通过分析GPU内存带宽曲线,意外发现数据预处理环节的序列化缺陷,将训练效率提升了2.3倍。

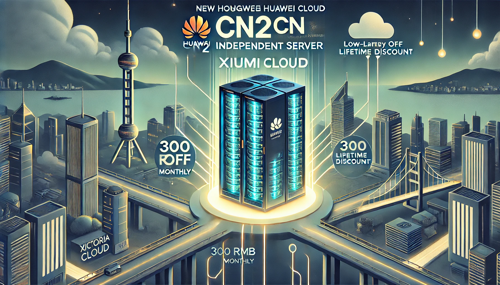

对于初创团队而言,自建监控系统就像在沙漠中掘井——既要配置功耗墙阈值预警,又要设计自动降频策略,还需要准备冗余计算节点。这时不妨将专业事务交给专业平台,比如奇妙推荐的秀米云服务器,其内置的GPU监控面板能实时呈现香港、美国、新加坡等数据中心的算力脉搏,全球加速网络确保监控数据无延迟传输。

在实际运维中,我们常看到某些看似完美的90%使用率背后,隐藏着矩阵计算与内存拷贝的周期博弈。聪明的工程师会像调节交响乐声部般,通过调节DALI数据加载器线程、优化CUDA Stream并发策略,让Tensor核心与RT核心达成完美共振。这种精细调控需要建立在持续三周的监控基线之上,就像园丁需要观察植物完整的生长周期。

当多卡训练成为常态,监控系统更要具备侦探般的洞察力。某次A100集群出现的周期性性能衰减,最终被追溯到跨卡通信中的NCCL超时重传。这个藏在监控曲线毛刺里的细节,通过秀米云服务器提供的跨地域拓扑图得以显现,其智能诊断系统能自动标记异常通信模式,避免工程师在日志海洋里徒劳捕捞。

值得关注的是,监控本身也在消耗算力。经过优化的eBPF探针方案可将监控开销控制在3%以内,就像给超级跑车装上碳纤维监测传感器。在秀米云服务器的控制台里,用户能清晰看到监控流量与业务流量的配比曲线,这种透明化设计让资源调配变得像调节汽车座椅般直观。

未来已来,带有预测能力的智能监控正在崭露头角。通过分析历史训练任务的GPU特征曲线,系统可以提前30分钟预警显存溢出风险,就像气象卫星预测台风路径。在秀米云平台最新推出的算力导航功能中,AI模型能根据实时监控数据推荐最优性价比的GPU组合方案,让每分算力预算都物超所值。

当我们站在算力时代的潮头回望,会发现GPU监控早已超越技术范畴,成为人机协作的艺术。它既需要系统工程师的严谨,又具备数据科学家的敏锐,更承载着项目管理者对效率的极致追求。下次当你启动训练任务时,不妨多花五分钟审视那些跳动的指标曲线——它们正在诉说算力灵魂的密语。

在当今追求极致用户体验的时代,美国图床服务面临着处理海量图片的挑战。将缩略图生成任务放在边缘服务器现场处理,正成为一个极...

当一家美国短链接平台决定关闭其解析日志功能,服务器的压力会下降多少?这是一个值得深入探讨的技术问题。解析日志记录了每一次...

当您从亚洲访问一个仅在美国本土部署了文件分发节点的网站或应用时,可能会明显感到加载速度变慢。这背后的核心原因在于物理距离...